这几天在看一些马克思主义的原典,看到了中文马克思主义文库这个网站,里面有很多历史上的文章,特别是一些中文的,有些史料性的文字,我过去都没有读过。今天下午动了心思,使用 wget -mp 命令正在镜像整个网站。到现在过去了三个来小时,还没有完全结束。现在我有点犹豫,我做的这件事情,或许是没有意义的?

一开始得知 wget 这个软件是在两千年左右上初中的时候,读王垠在清华大学时的网站时得知的,当时也是我少有的 Linux 知识获取渠道吧。那个年代我家里也没有宽带网络,还是用的 56K 小猫来上网,所以当我看到王垠在页面上讲了用 wget 来把他网站上全部文章下载下来的命令后,我如获至宝。不过后来我自己实践后发现还是有些差异,比如王垠的命令里设置了下载层级,我是想把整个网站都镜像下来。不过王垠已经提供了足够的思路,我通过查看文档,最终只记住了 wget -mp 网址 这一种参数,也基本上够用了。

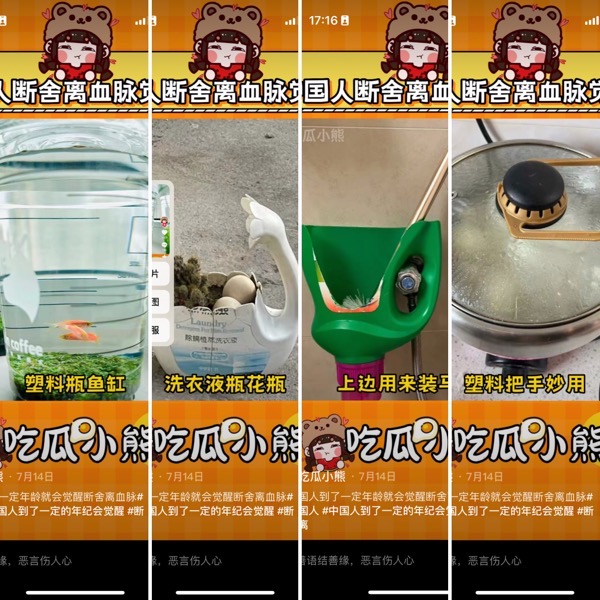

前几天我从网上看到一篇好玩的文章,印象里好像是小红书,不过现在找不到原文了,我搜索了一下,从抖音上找到了一个引用同样图片的视频,截了几个图放在这里:

当时是觉得有趣,不过心里也有十分的认同。我知道“断舍离”这个词也挺早的了,也买了近藤麻里奈的书,结果一直就没有真正实行过。细究其中的难度,应该就在我这种不舍得扔东西的性格吧。现在网上也有不少批评极端“断舍离”的做法,并把其归结于中国人的反断舍离的基因,我觉得挺有道理。

因此这么一想,我用 wget 下载整个网站的行为应该也和这种因素有关。前几年用小猫上网的时候,为了省钱,也为了不占用电话线,常常先把网站上我想读的页面在后台打开,然后断网后再慢慢读。所以对于有价值的网站,我也是常常用 wget 全站下载。后来渐渐的我有意改掉了这个习惯,改用社会化书签等工具来保存网页,还有段时间把收藏夹维护到了我的个人维基上。当我一度以为这样会万无一失的时候,很多网站现在已经 404 了。这个时候我只有羡慕 Zoom Quiet 的先见之明了,看他在网上公开的 Scrapbook 插件收藏的网页,那真的是让人流口水呀。

从另一个角度上说,我用 wget 下载的网站,其实多数情况下,收藏居多。偶尔会上去找一些文章读一下,但其实用起来远没有那么频繁。就拿这次的马克思主义著作来说吧,现在我已经没有时间再长时间阅读这些原典了。甚至过了这个兴奋劲,我联打开都未必愿意,反而会觉得它们是硬盘的负担吧。

多年前找他们索取过光盘(见链接),可惜收到后就是坏的,换了几个光驱都没读出来。于是,干脆mirror了一份,压缩之后大约20GB吧。BTW,上面说的王垠的网站我也mirror过一份……

光盘的可靠性或许没那么大吧,宽带网络普及后,光盘也就逐渐式微了。我大概 2005 年前后在线申请过 Ubuntu 的安装光盘,质量倒是不错。我猜这个网站主要由爱好者来操作,为控制成本可能光盘质量就无法保证了。

王垠的网站在当时看来,对桌面 Linux 用户/学习者来说简直算是包罗万象了,我很多知识都是从他的网站上获得的。今天他的网站的实用性对我来说就大大降低了 🙂

可能因为长期的物资匮乏,大部分小黄人有仓鼠癖。

比如我经常忍不住收集各种电子资料,快递盒子……

当年还有专门用来离线看网页的工具。“网文快捕”吧好像。